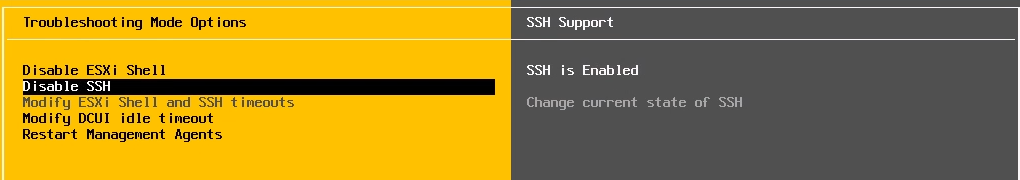

在vSphere平台下安装vGPU驱动之前需要打开ESXi的SSH服务,方便来传输vib驱动安装包以及后面一些命令行的操作。

ESXi需要加入vCenter,vGPU相关的一些配置都需要在vCenter下来修改。

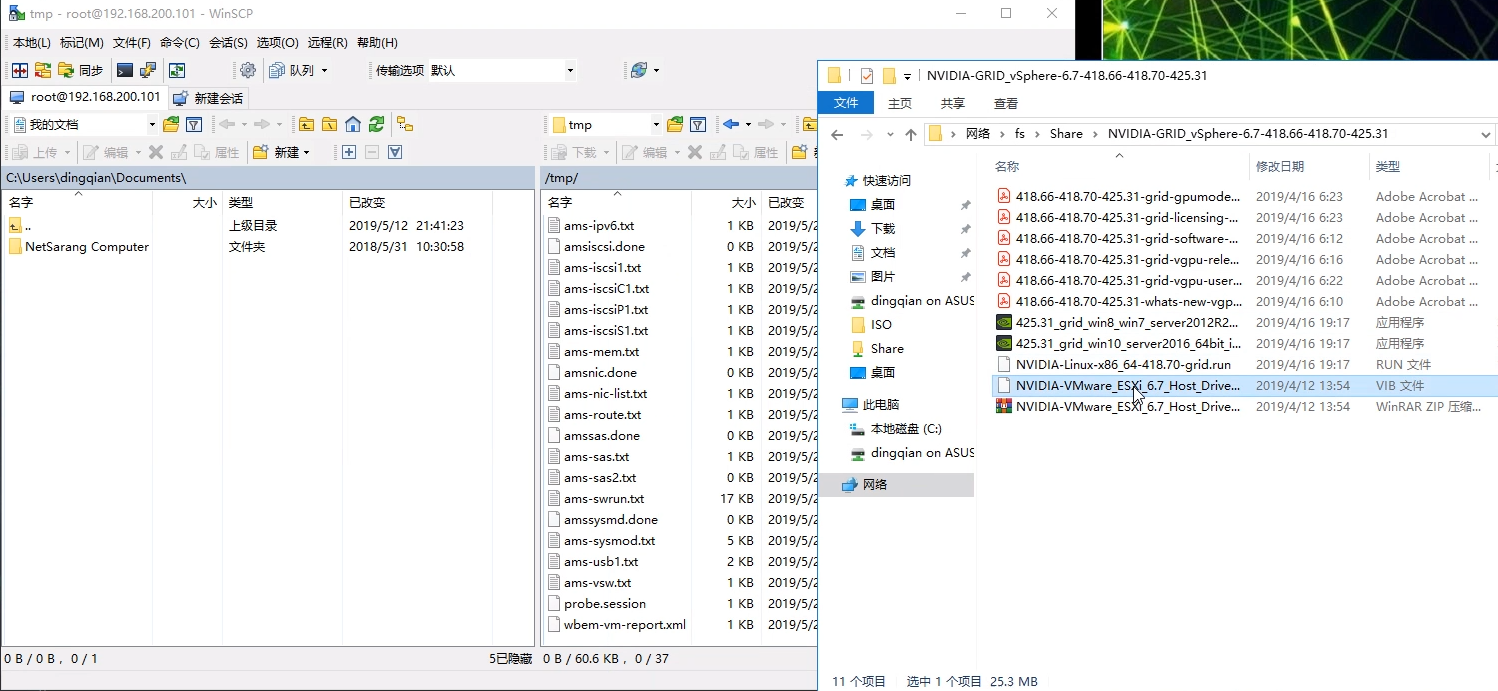

使用WinSCP把驱动vib传到ESXi的/tmp目录下

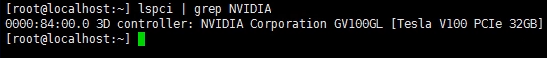

安装驱动之前先检查一下GPU是否被正常识别到,SSH到ESXi,使用命令:lspci | grep NVIDIA 来检查。

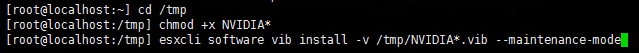

到/tmp目录下,赋予vib驱动包可执行权限,然后使用esxcli命令进行安装,注意ESXi主机需要处于维护模式,可以在web client上修改,也可以在安装时加上--maintenance-mode参数。

cd /tmp

chmod +x NVIDIA*

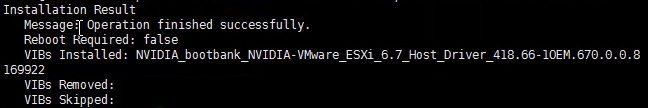

esxcli software vib install -v /tmp/NVIDIA*.vib --maintenance-mode

等待几分钟,安装成功以后会有提示信息,可能在安装信息中提示不需要重启,但是强烈建议重启一下主机来验证驱动是否正常,有碰到过重启以后驱动报错的情况。

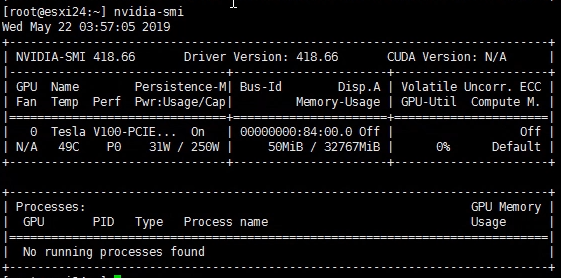

重启完主机以后使用 nvidia-smi 命令来验证驱动是否正常,正常情况下能看到类似如下信息:

特别注意2点:1、ECC模式是否显示off 2、默认情况下vSphere会使用vsga模式,而不是vGPU模式,所以能看到最下面xorg条目,这个我们后面改。

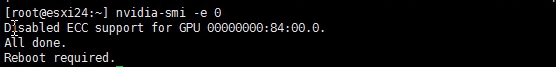

在部分时候,特别是使用全新的GPU,可能会看到nvidia-smi信息里面ECC区域不是off状态,而是0,而在GRID 9.0版本之前,要使用vGPU必须关闭ECC模式。

使用命令来关闭ECC,注意,启用或者关闭ECC都需要重启主机。

nvidia-smi -e 0

更多关于ECC的信息,请参考:

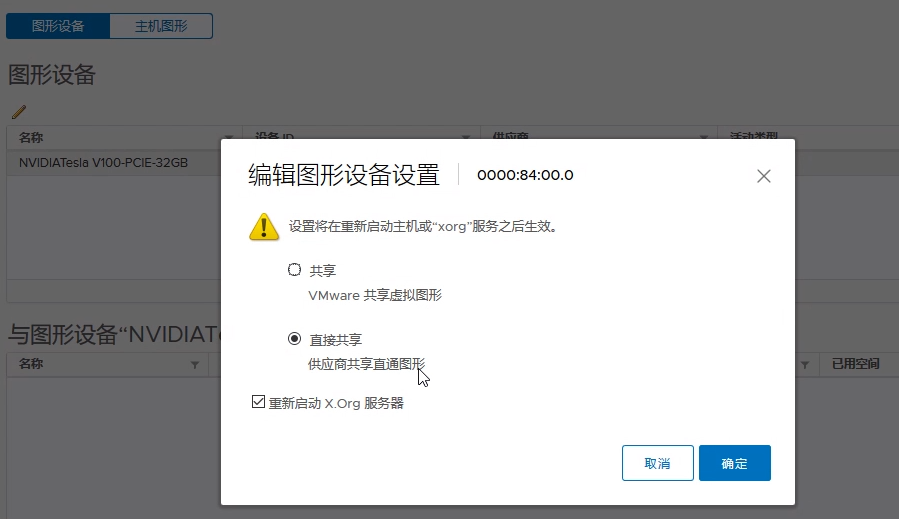

在确认驱动状态没问题以后,我们登陆vCenter,定位到主机-配置-图形,编辑主机图形设置,可以看到默认是共享模式,也就是vsga,我们需要切换到“直接共享“才能使用vGPU。

2种GPU分配策略,在有多个GPU的时候生效。

默认最佳性能模式,会在所有可能的GPU上去运行虚拟机,即VM1运行在GPU1、VM2运行在GPU2,以此类推,尽可能平均的分布虚拟机,不会让GPU闲着。

GPU整合模式,会在一个GPU核心上运行先启动的虚拟机,直到当前GPU没有资源才会去使用下一个GPU核心,这个模式多用在同一台服务器上运行多个vGPU profile的情况下。

除了主机的图形选项,针对每个GPU也都可以单独设置共享模式,第一次使用需要在这里再切换一下,主要是需要重启xorg服务来改变配置,不同vSphere版本界面可能不能,部分vSphere 6.5早期版本需要手动重启xorg服务。

更改成功以后就没有xorg条目了,可以开始使用vGPU了!

转自:https://www.dingqian.net/index.php/archives/52/

Copyright © 2019-2024 青岛希诺智能科技有限公司版权所有 备案号:鲁ICP备19042003号-1

技术支持:微动力网络